Artificial Intelligence

OpenAI GPT-4o mini: moc AI w połączeniu z przystępnością cenową

W dążeniu do demokratyzacji sztucznej inteligencji OpenAI ujawniło GPT-4o mini, nowy, ekonomiczny mały model. Ten najnowszy dodatek do zestawu modeli językowych OpenAI ma na celu osiągnięcie równowagi między zaawansowanymi możliwościami a przystępnością cenową, potencjalnie otwierając drzwi do szerszego zastosowania technologii sztucznej inteligencji w różnych sektorach.

GPT-4o mini reprezentuje strategiczną zmianę w podejściu OpenAI do rozwoju sztucznej inteligencji. Chociaż firma znana jest z przesuwania granic dzięki coraz potężniejszym modelom, takim jak GPT-4, ta nowa oferta skupia się na zwiększaniu dostępności zaawansowanej sztucznej inteligencji. GPT-4o mini został zaprojektowany tak, aby zapewnić wysoką jakość wykonania w szerokim zakresie zadań, ale za ułamek kosztów jego większych odpowiedników.

Wprowadzenie GPT-4o mini mogłoby znacząco rozszerzyć zakres zastosowań AI poprzez obniżenie bariery wejścia dla programistów i firm. Oferując model, który jest zarówno wydajny, jak i ekonomiczny, OpenAI odpowiada na jedno z kluczowych wyzwań związanych z wdrażaniem sztucznej inteligencji: wysokie koszty związane z wykorzystaniem najnowocześniejszych modeli językowych. Posunięcie to mogłoby potencjalnie przyspieszyć innowacje w dziedzinach, w których integracja sztucznej inteligencji była wcześniej zaporowa pod względem kosztów.

OpenAI

Zrozumienie GPT-4o Mini

GPT-4o mini to model językowy na małą skalę, który oferuje ogromne możliwości pod względem możliwości. Do jego najważniejszych cech należą:

- Zaawansowane przetwarzanie języka: Pomimo mniejszych rozmiarów, GPT-4o mini wykazuje zaawansowane możliwości rozumienia języka i generowania komunikatów.

- Możliwości multimodalne: Model obsługuje zarówno dane tekstowe, jak i wizyjne, a w przyszłości planowane jest rozszerzenie go na dźwięk. Ta wszechstronność sprawia, że nadaje się do szerokiego zakresu zastosowań.

- Ulepszone rozumowanie: GPT-4o mini wykazuje zwiększoną wydajność w przypadku złożonych zadań wnioskowania, przewyższając wielu swoich konkurentów zajmujących się małymi modelami.

- Opłacalność: Zaprojektowany do zastosowań o dużej objętości, GPT-4o mini oferuje bardziej ekonomiczne rozwiązanie do zadań, które nie wymagają pełnej mocy większych modeli.

Porównanie z poprzednimi modelami (GPT-3.5 Turbo, GPT-4)

Aby naprawdę docenić postęp, jaki przynosi GPT-4o mini, konieczne jest porównanie go z poprzednikami:

Porównanie GPT-3.5 Turbo:

- Wydajność: GPT-4o mini osiąga 82% w teście MMLU, co stanowi znaczną poprawę w porównaniu z 3.5% GPT-70 Turbo.

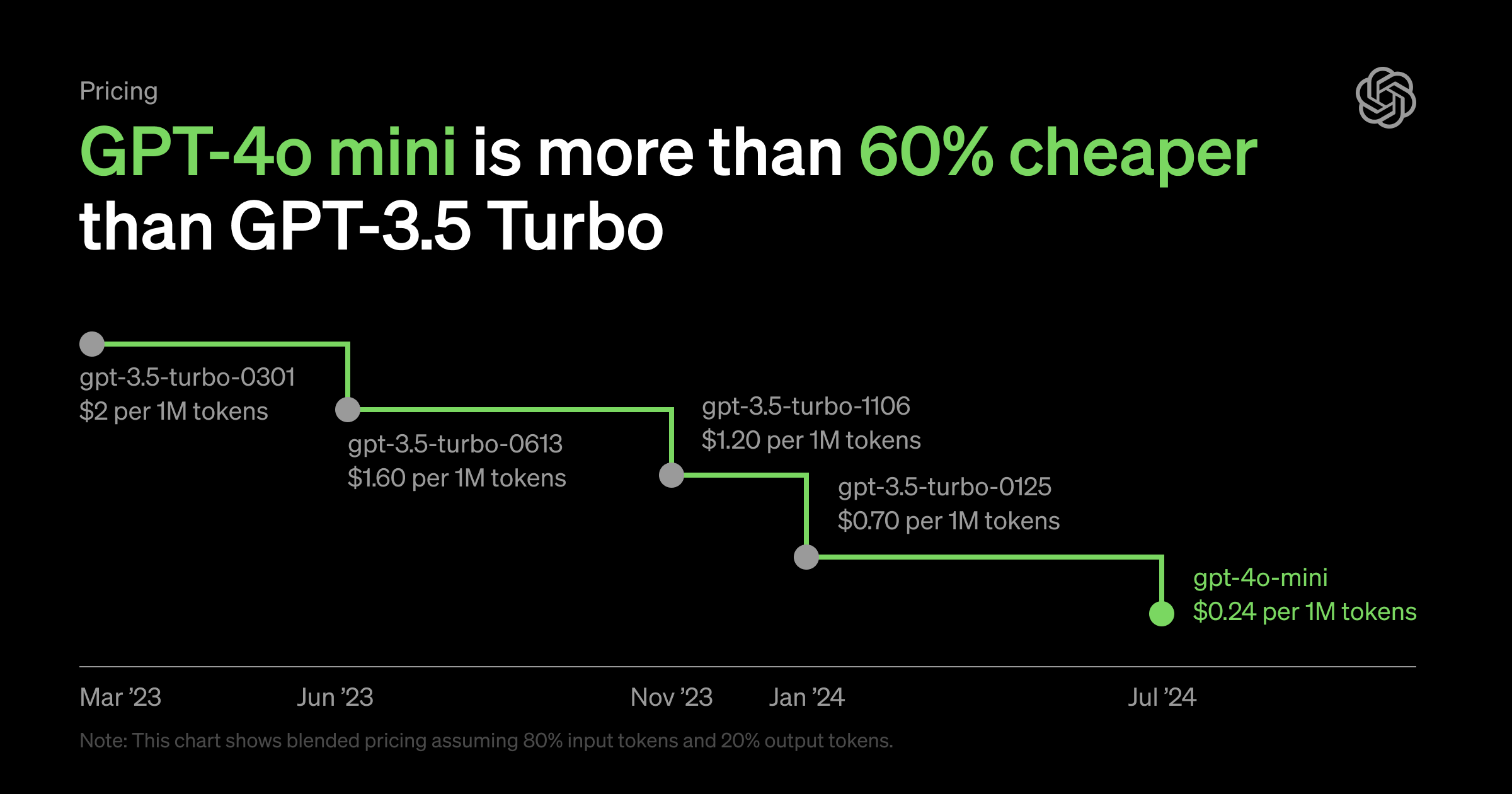

- Koszty: GPT-4o mini jest o ponad 60% tańszy niż GPT-3.5 Turbo, co czyni go bardziej atrakcyjną opcją w przypadku wdrożeń na dużą skalę.

- Okno kontekstowe: Dzięki oknu kontekstowemu tokenu o wielkości 128 KB, GPT-4o mini może przetwarzać znacznie dłuższe dane wejściowe w porównaniu z limitem tokenów 3.5K w GPT-4 Turbo.

Porównanie GPT-4:

Chociaż GPT-4 pozostaje lepszy pod względem ogólnych możliwości, GPT-4o mini oferuje lżejszą i tańszą alternatywę do zadań, które nie wymagają pełnej mocy GPT-4. Takie umiejscowienie pozwala programistom wybrać model najbardziej odpowiedni do ich konkretnego przypadku użycia, optymalizując zarówno wydajność, jak i koszty.

OpenAI

Pozycjonowanie na rynku małych modeli

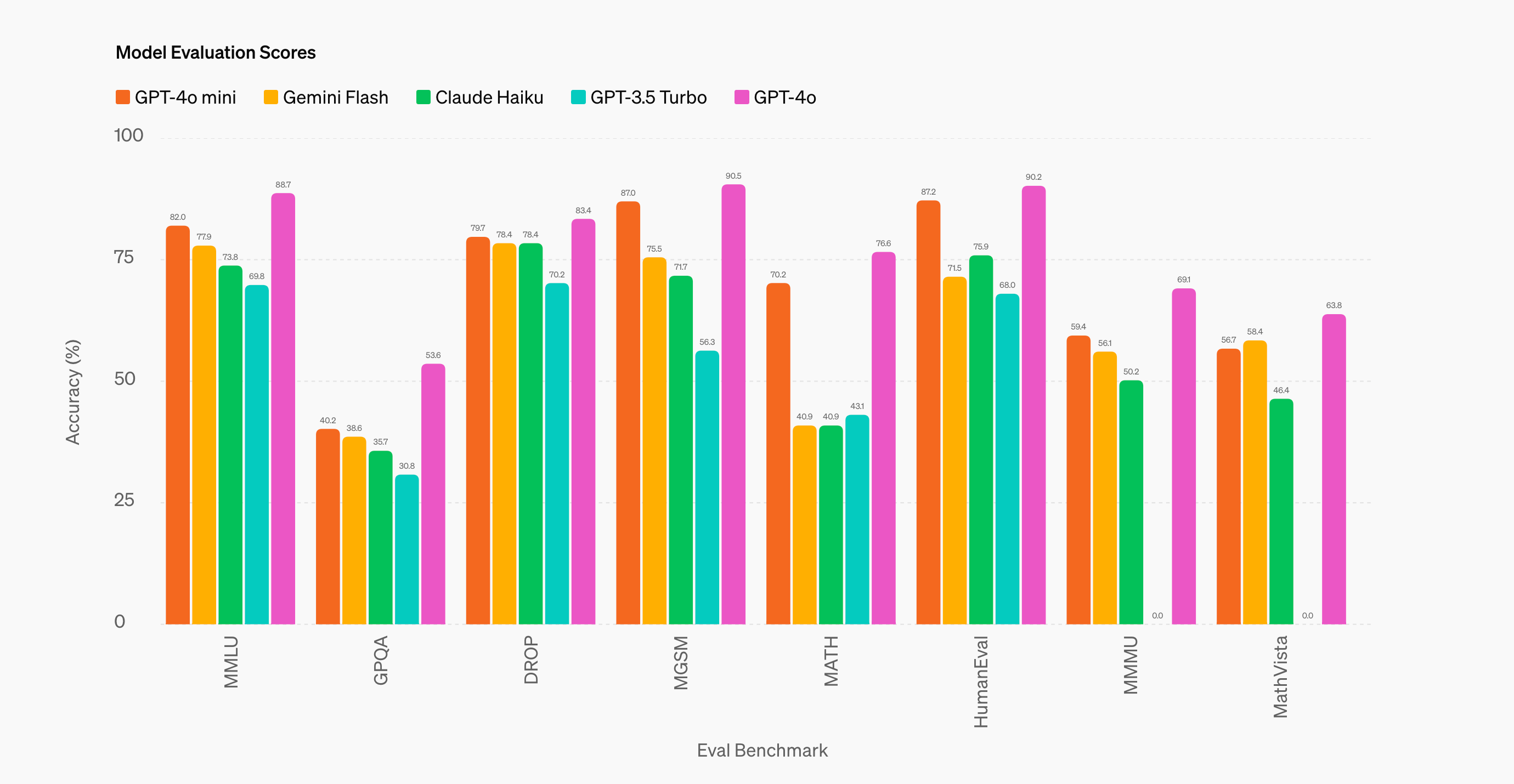

GPT-4o mini wkracza w konkurencyjny krajobraz małych modeli AI, w tym oferty takie jak Gemini Flash i Claude Haiku. Jednakże nowy model OpenAI ma na celu wyróżnić się doskonałą wydajnością i opłacalnością. Wczesne testy porównawcze sugerują, że GPT-4o mini przewyższa swoich konkurentów w kluczowych obszarach, takich jak rozumowanie matematyczne i biegłość w kodowaniu, co czyni go atrakcyjną opcją dla programistów chcących skalować potężne aplikacje AI bez ponoszenia kosztów związanych z poprzednimi, pionierskimi modelami.

Specyfikacja techniczna

Rozmiar okna kontekstowego

Jedną z wyróżniających się cech GPT-4o mini jest rozbudowane okno kontekstowe zawierające 128,000 XNUMX tokenów. To duże okno kontekstowe zmienia zasady gry w wielu aplikacjach, umożliwiając modelowi przetwarzanie i zrozumienie znacznie dłuższych danych wejściowych. Ta funkcja umożliwia bardziej zniuansowane interakcje i otwiera możliwości zadań wymagających analizy obszernych dokumentów lub utrzymywania długoterminowego kontekstu w rozmowach.

Ceny tokenów

GPT-4o mini wprowadza wysoce konkurencyjną strukturę cenową:

- 15 centów za milion tokenów wejściowych

- Tokeny wyjściowe o wartości 60 centów za milion

Ten model cenowy stanowi znaczną obniżkę w porównaniu z poprzednimi modelami pionierskimi, umożliwiając programistom efektywniejsze tworzenie i skalowanie potężnych aplikacji AI. Opłacalność GPT-4o mini może mieć szczególny wpływ na start-upy i mniejsze firmy, które wcześniej miały trudności z integracją zaawansowanych funkcji sztucznej inteligencji w swoich produktach ze względu na ograniczenia budżetowe.

Obsługiwane wejścia i wyjścia

Obecnie GPT-4o mini obsługuje:

- Wejścia i wyjścia tekstowe

- Wejścia wizyjne

Na szczególną uwagę zasługuje zawarcie możliwości wizyjnych w małym, ekonomicznym modelu, ponieważ otwiera możliwości zastosowań multimodalnych, które wcześniej były ograniczone do droższych modeli. OpenAI ogłosiło także plany rozszerzenia możliwości GPT-4o mini o wejścia i wyjścia audio w przyszłości, co jeszcze bardziej zwiększy jego wszechstronność i potencjalne zastosowania.

Data graniczna wiedzy

Baza wiedzy GPT-4o mini jest datowana na październik 2023 r. Ten stosunkowo niedawny termin gwarantuje, że model ma dostęp do aktualnych informacji, dzięki czemu nadaje się do zastosowań wymagających aktualnej wiedzy. Użytkownicy powinni jednak mieć świadomość tego ograniczenia podczas wdrażania modelu do zadań, które mogą wymagać nowszych informacji.

Oferując tę kombinację zaawansowanych możliwości, opłacalności i wszechstronności, GPT-4o mini stanowi znaczący krok w kierunku zwiększenia dostępności sztucznej inteligencji i płynnej integracji z szeroką gamą aplikacji. Gdy programiści i firmy zaczną odkrywać jego potencjał, możemy zaobserwować nową falę innowacji w rozwiązaniach opartych na sztucznej inteligencji w różnych branżach.

Wydajność i możliwości

GPT-4o mini wykazuje imponującą wydajność w różnych testach porównawczych, pozycjonując go jako potężnego gracza na rynku małych modeli.

Wyniki porównawcze

MMLU (Rozumienie języka ogromnej wielozadaniowości):

- GPT-4o mini: 82%

- Błysk Gemini 1.5: 79%

- Claude 3 Haiku: 75%

MGSM (wielozadaniowość w szkole matematycznej):

- GPT-4o mini: 87%

- Błysk Gemini 1.5: 78%

- Claude 3 Haiku: 72%

Zdolności wnioskowania multimodalnego

GPT-4o mini wyróżnia się w zadaniach multimodalnych, wykazując dobrą wydajność w testach porównawczych takich jak MMMU (multimodalne zrozumienie wielu zadań wielozadaniowych). Jego zdolność do przetwarzania danych wejściowych zarówno tekstowych, jak i wizualnych umożliwia bardziej złożone zadania rozumowania, które łączą różne typy informacji.

Znajomość matematyki i kodowania

Poza wydajnością MGSM, GPT-4o mini wykazuje duże możliwości w zadaniach związanych z kodowaniem. W teście HumanEval, który mierzy wydajność kodowania, GPT-4o mini uzyskał 87.2%, wyprzedzając zarówno Gemini Flash (71.5%), jak i Claude Haiku (75.9%). Dzięki temu jest to potężne narzędzie dla programistów poszukujących ekonomicznej pomocy przy zadaniach programistycznych.

Przypadki użycia i aplikacje

Proste zadania o dużej objętości

GPT-4o mini idealnie nadaje się do zastosowań wymagających częstych i szybkich interakcji AI. Przykłady obejmują:

- Chatboty obsługi klienta

- Systemy moderowania treści

- Narzędzia do analizy danych w czasie rzeczywistym

Odpowiedzi tekstowe w czasie rzeczywistym

Szybkość i wydajność modelu sprawiają, że nadaje się on do zastosowań wymagających generowania lub analizy tekstu w czasie rzeczywistym, takich jak:

- Pomoc na czacie na żywo

- Natychmiastowe tłumaczenie językowe

- Podsumowanie treści w czasie rzeczywistym

Potencjalne przyszłe zastosowania (audio, wideo)

Dzięki planowanej obsłudze wejść i wyjść audio, GPT-4o mini może umożliwić nowe zastosowania w:

- Sterowani głosem asystenci AI

- Systemy zamiany mowy na tekst i tekstu na mowę w czasie rzeczywistym

- Analiza i generowanie treści audio

Dostępność i integracja

Dostęp API dla programistów

Programiści mogą uzyskać dostęp do GPT-4o mini poprzez API OpenAI, co pozwala na bezproblemową integrację z istniejącymi aplikacjami lub rozwój nowych narzędzi opartych na sztucznej inteligencji.

Integracja ChatGPT dla konsumentów

GPT-4o mini jest integrowany z aplikacją internetową i mobilną ChatGPT, dzięki czemu jego możliwości są bezpośrednio dostępne dla konsumentów. Integracja ta może znacząco poprawić wygodę użytkowników ChatGPT.

Plany wdrożeń dla przedsiębiorstw

OpenAI ogłosiło, że użytkownicy korporacyjni uzyskają dostęp do GPT-4o mini od przyszłego tygodnia. Ta strategia wdrażania gwarantuje, że firmy będą mogły szybko wykorzystać możliwości modelu w celu ulepszenia swoich produktów i usług.

Często zadawane pytania: GPT-4o mini

Jak GPT-4o mini wypada w porównaniu z GPT-4 pod względem wydajności?

GPT-4o mini oferuje wysoką wydajność jak na swój rozmiar, ale GPT-4 pozostaje ogólnie lepszy. Wersja mini została zaprojektowana z myślą o oszczędności i szybkości w mniej skomplikowanych zadaniach.

Jakie są główne zastosowania GPT-4o mini?

Kluczowe zastosowania obejmują zadania wymagające dużej liczby użytkowników, takie jak chatboty, moderowanie treści i analiza tekstu w czasie rzeczywistym. Idealnie nadaje się do scenariuszy wymagających szybkich i opłacalnych reakcji sztucznej inteligencji.

Czy GPT-4o mini obsługuje multimodalność od chwili premiery?

Tak, GPT-4o mini obsługuje wprowadzanie tekstu i obrazu w momencie premiery, a w przyszłości planuje dodać funkcje audio.

Które firmy już korzystają z GPT-4o mini?

Chociaż nie podano konkretnych nazw firm, do pierwszych użytkowników zaliczają się prawdopodobnie firmy z branży obsługi klienta, tworzenia treści i analizy danych, poszukujące opłacalnych rozwiązań AI.

Jak GPT-4o mini poprawia wydajność przetwarzania danych?

GPT-4o mini zwiększa wydajność przetwarzania danych dzięki krótszym czasom wnioskowania i niższym wymaganiom obliczeniowym, umożliwiając bardziej ekonomiczną obsługę zadań o dużej objętości.